Amazon Web Services, Amazon EC2 Trn3 UltraServer’ların genel kullanıma sunulduğunu duyurdu.

Yapay zekâ modelleri boyut ve karmaşıklık açısından büyüdükçe işletim ve ağ altyapısının sınırlarını zorlarken, müşteriler eğitim sürelerini ve gecikmeleri azaltmak istiyor. En güncel modelleri eğitmek, artık yalnızca çok az sayıda kuruluşun karşılayabileceği altyapı yatırımları gerektiriyor. Büyük ölçekli yapay zekâ uygulamaları ise hızla kontrolden çıkabilecek işlem kaynaklarına ihtiyaç duyuyor. Bugün mevcut olan en hızlı sunucular bile daha hızlı eğitim süresi sağlamakta yetersiz kalırken, gerçek zamanlı çıkarım ihtiyaçları tek sunuculu mimarilerin kapasitesini zorluyor.

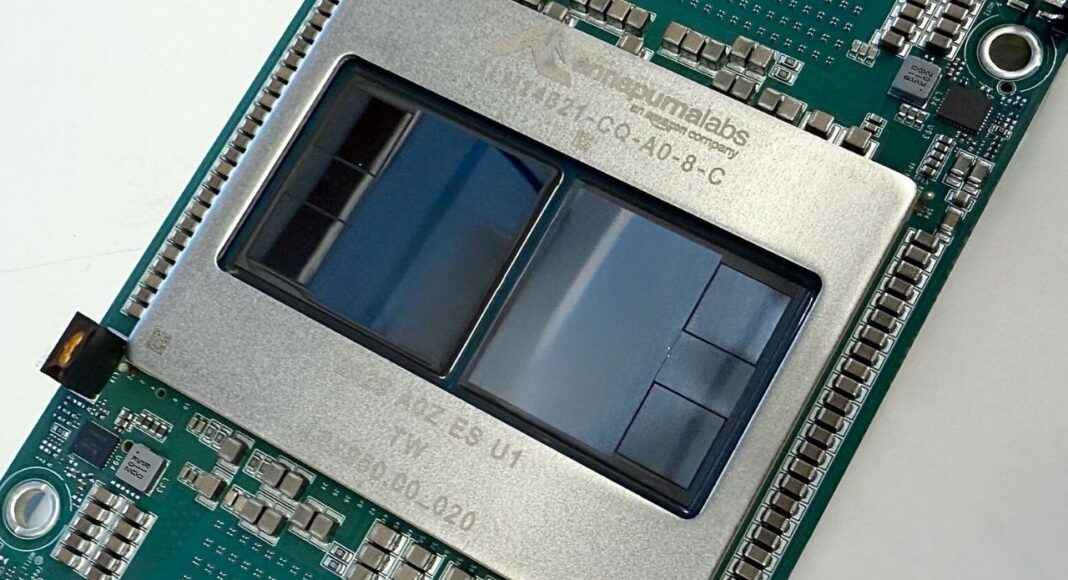

Müşterilerin bu kısıtların üstesinden gelmelerine yardımcı olmak adına, AWS’in 3nm teknolojisi üzerine kurulu yeni Trainium3 çipiyle destekli Trn3 UltraServer’lar, her büyüklükten kuruluşun daha büyük yapay zekâ modellerini daha hızlı eğitmelerine ve daha düşük maliyetle daha fazla kullanıcıya hizmet vermelerine olanak sağlıyor. Böylece yarının en iddialı yapay zekâ projeleri için gereken işlem gücüne erişimi demokratikleştiriyor.

Trainium3 UltraServer’lar, yeni nesil yapay zekâ iş yükleri için özel olarak üretildi

Trn3 UltraServer’lar tek bir entegre sisteme 144 adede kadar Trainium3 çip sığdırarak Trainium2 UltraServer’lara göre 4,4 kata kadar daha fazla işlem performansı sunuyor. Böylece, daha önce uygulanamayan veya fazla maliyetli olan yapay zekâ modelleriyle çalışılabiliyor. Modelleri daha hızlı eğiterek süreyi aylardan haftalara indiriyor, kullanıcılardan gelen istekleri aynı anda yanıtlıyor ve hem pazara sunma süresini hem de işletme maliyetlerini azaltıyor.

Trn3 UltraSever’ların OpenAI’ın açık ağırlıklı modeli GPT-OSS’i kullanarak yapılan testlerinde müşteriler Trn2 UltraServer’lara göre çip başına 3 kat daha yüksek verim elde ederken, 4 kat daha hızlı yanıt süreleri sunabiliyorlar. Bu da işletmelerin yapay zekâ uygulamalarını en yüksek talepleri daha düşük altyapı ayak iziyle ölçeklendirebileceği, böylece çıkarım isteği başına maliyeti düşürürken doğrudan kullanıcı deneyimini iyileştirebileceği anlamına geliyor.

Bu iyileştirmeler, Trainium3’ün amaca yönelik özel olarak üretilen çipi sayesinde elde ediliyor. Bu çip, gelişmiş tasarım inovasyonları, çipler arası veri geçişini hızlandıran optimize edilmiş ara bağlantıları ve daha büyük yapay zekâ modellerini işlerken ortaya çıkan darboğazları ortadan kaldıran gelişmiş bellek sistemleri ile çığır açan bir performans elde ediyor. Trainium3, yalnızca performansın ötesinde, önceki nesillere göre yüzde 40 enerji verimliliği gibi önemli derecede enerji tasarrufu sağlıyor. Bu verimlilik, AWS veri merkezlerinin çevresel etkisini azaltırken daha uygun maliyetli yapay zekâ altyapıları kurulmasını sağlayarak, büyük ölçekte fayda sunuyor.

Ölçeklenebilirlik için tasarlanmış gelişmiş ağ altyapısı

AWS, Trn3 UltraServer’ı çip mimarisinden yazılım yığınına kadar dikey olarak entegre bir sistem olarak tasarladı. Bu entegrasyonun merkezinde, genellikle dağıtık yapay zekâ hesaplamasını sınırlayan iletişim sorunlarını ortadan kaldırmak için tasarlanmış ağ altyapısı yer alıyor. Yeni NeuronSwitch-v1, her UltraServer içinde 2 kat daha fazla bant genişliği sağlarken, geliştirilmiş Neuron Fabric ağı, çipler arasındaki bağlantı gecikmelerini 10 mikrosaniyenin altına indiriyor.

Aracı sistemleri, uzman karışımı modelleri (MoE) ve pekiştirmeli öğrenim uygulamaları da dahil olmak üzere geleceğin yapay zekâ iş yükleri, işlemciler arasında sorunsuz bir şekilde aktarılabilmesi için büyük miktarda veri gerektiriyor. AWS tarafından tasarlanan bu ağ, daha önce mümkün olmayan anlık yanıtlar veren yapay zekâ uygulamaları geliştirilmesine olanak tanıyarak, veriyi anında işleyip harekete geçen gerçek zamanlı karar sistemleri ve gecikmesiz, doğal tepki veren akıcı sohbet tabanlı yapay zekâ gibi yeni kullanım alanlarının kapısını açıyor.

Ölçeklendirmeye ihtiyaç duyan müşteriler için, EC2 UltraClusters 3.0, önceki neslin 10 katı kapasiteye sahip 1 milyon Trainium çipe kadar binlerce UltraServer’ı bağlayabiliyor ve kullanıcılara bir sonraki nesil temel modelleri eğitmek için gerekli altyapıyı sunuyor. Bu ölçek, trilyonlarca belirteçten oluşan veri kümeleri üzerinde çok modlu modelleri eğitmekten milyonlarca eşzamanlı kullanıcı için gerçek zamanlı çıkarım çalıştırmaya kadar, daha önce mümkün olmayan projelerin hayata geçirilmesini sağlıyor.

Müşteriler şimdiden sınır ötesi ölçekte sonuçlar görüyor

Müşteriler, Trainium’dan şimdiden önemli bir değer elde ediyor. Anthropic, Karakuri, Metagenomics, Neto.ai, Ricoh ve Splashmusic gibi şirketler, alternatiflere kıyasla eğitim maliyetlerini yüzde 50’ye kadar azalttı. AWS’in temel modeller için sunduğu yönetilen servisi Amazon Bedrock, halihazırda Trainium3 üzerinde üretim iş yüklerini gerçekleştiriyor ve bu da çipin kurumsal ölçekte kullanıma hazır olduğunu gösteriyor.

Gerçek zamanlı etkileşimli deneyimleri destekleyen, verimli ve optimize edilmiş üretken yapay zekâ video ve görüntü modelleri üzerine uzmanlaşmış bir yapay zekâ laboratuvarı olan Decart gibi öncü yapay zekâ şirketleri, Trainium3’ün yeteneklerini gerçek zamanlı üretken video gibi yoğun iş yüklerinde kullanıyor ve GPU maliyetinin yarısına 4 kat daha hızlı kare üretimi elde ediyor. Bu, hesaplama yoğun uygulamaları büyük ölçekte pratik hale getirerek, kişiselleştirilmiş canlı deneyimlerden büyük ölçekli simülasyonlara kadar tamamen yeni kategorilerde etkileşimli içeriklerin mümkün olmasını sağlıyor. Project Rainier ile AWS, Anthropic ile iş birliği yaparak 500.000’den fazla Trainium2 yongasını dünyanın en büyük yapay zekâ hesaplama kümesine bağladı. Bu küme, Anthropic’in önceki nesil modellerini eğitmek için kullandığı altyapının beş katı büyüklüğünde. Trainium3, bu kanıtlanmış temelin üzerine inşa edilerek UltraCluster mimarisini genişletiyor ve bir sonraki nesil büyük ölçekli yapay zekâ hesaplama kümeleri ile sınır modelleri için çok daha yüksek performans sunuyor.

Gelecek nesil Trainium’a bakış

AWS, şu anda Trainium4 üzerinde çalışıyor. Bu ürün, yeni nesil öncü eğitim ve çıkarımları desteklemek için en az 6 kat daha yüksek işlem performansı (FP4), 3 kat daha yüksek FP8 performansı ve 4 kat daha fazla bellek bant genişliği dahil olmak üzere tüm boyutlarda önemli performans iyileştirmeleri sağlayacak şekilde tasarlanıyor. Sürekli donanım ve yazılım optimizasyonlarıyla birleştirildiğinde, temel iyileştirmelerin çok ötesinde performans artışları elde edilmesi bekleniyor. Trainium4’teki 3 kat FP8 performans artışı, temel bir sıçramayı temsil ediyor. Yapay zekâ modelleri en az üç kat daha hızlı eğitebilecek veya en az üç kat daha fazla çıkarım isteği çalıştırılabilecek. Ayrıca, sürekli yazılım geliştirmeleri ve iş yüküne özel optimizasyonlar sayesinde ek kazançlar elde edilebilecek. FP8, modern yapay zekâ iş yükleri için model doğruluğunu hesaplama verimliliğiyle dengeleyen, endüstri standardı bir hassasiyet formatı.

Daha yüksek ölçeklenebilir performans sunmak için Trainium4, NVIDIA NVLink Fusion yüksek hızlı çipler arası bağlantı teknolojisini destekleyecek şekilde tasarlanıyor. Bu entegrasyon, Trainium4, Graviton ve EFA’nın ortak MGX raflarında sorunsuz bir şekilde birlikte çalışmasını sağlayarak hem GPU hem de Trainium sunucularını destekleyen uygun maliyetli, raf ölçeğinde bir yapay zekâ altyapısı sunuyor. Sonuç olarak, zorlu yapay zekâ model eğitimi ve çıkarım iş yükleri için optimize edilmiş, esnek ve yüksek performanslı bir platform ortaya çıkıyor.